用戶主要是高校/科研機構和航空航天、汽車、電子/高科技、船舶、土木工程、制造和生物工程等行業,包括汽車碰撞、爆炸反應,甚至主動脈人工心臟瓣膜在血液泵送通過時的復雜啟閉行為。

1976年,LS-DYNA由美國Lawrence Livermore國家實驗室的J.O.Hallquist博士主持開發。

1988年,LSTC(Livermore Software Technology Corp.)公司成立,LS-DYNA開始商業化。

1996年,LSTC與ANSYS合作推出ANSYS/LS-DYNA,結合了ANSYS的前、后處理工具和LS-DYNA求解器。

2019年,Ansys收購LSTC。

- 如何提高求解器的計算效率?

- 本地和云上仿真并行計算是一回事嗎?

- 什么類型的云端資源更適合跑LS-DYNA?

- LS-DYNA大規模并行計算效率優化明顯嗎?

- 在云上運行會改變用戶本地的使用習慣嗎?

今天我們通過一個實證來解答用戶在使用LS-DYNA上云過程中的這些關鍵問題。

用戶需求

某車企CAE部門建設有本地機房,日常工作使用單機計算,不僅算得慢,且由于資源未得到統一管理,經常出現高性能機器排隊、低配機器空閑的情況,嚴重拖慢生產設計進度。

隨著公司業務的發展,CAE部門將在不久的將來面臨更大的業務壓力,部門負責人有意將部分LS-DYNA任務擴展到云端,但由于沒有接觸過云,有很多疑問。

實證目標

1、LS-DYNA任務能否在云端有效運行?計算效率能否優化?

2、LS-DYNA應用最適合的云端資源是哪種類型?

3、LS-DYNA大規模并行場景是否依然能保持線性?

4、fastone能否進行資源統一管理,同時保持用戶本地的使用習慣?

實證參數

平臺:

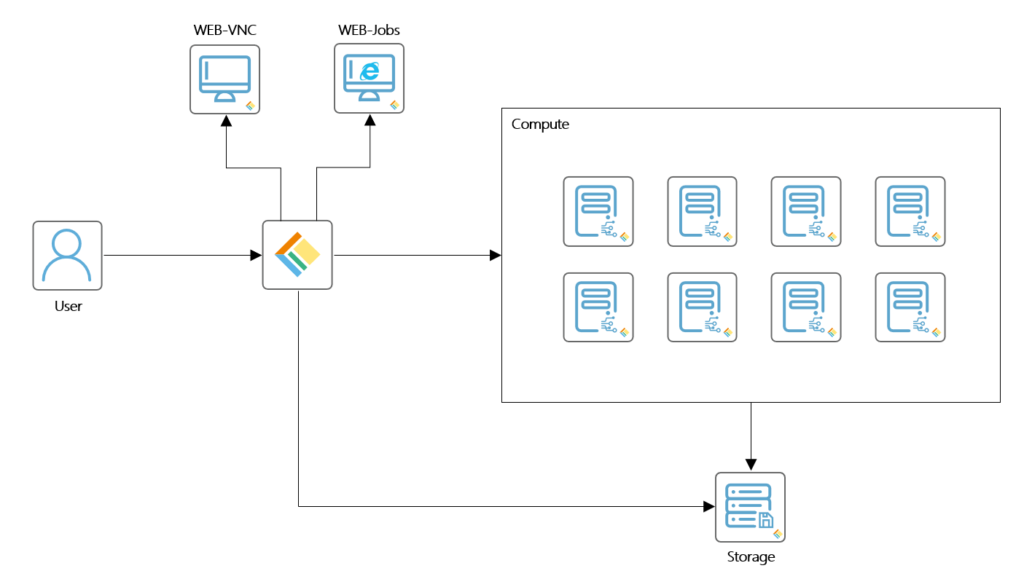

fastone企業版產品

應用:

LS-DYNA MPP版本

操作系統:

Linux CentOS 7.4

調度器:

SLURM

適用場景:

仿真材料在承受短時高強度載荷時的響應,如碰撞、跌落以及金屬成型過程中發生的情況

云端硬件配置:

計算優化型實例

通用型實例

內存優化型實例

網絡加強型實例

技術架構圖:

LS-DYNA支持基于Linux、Windows和UNIX的大規模集群的并行仿真計算,分為MPP(Massively Parallel Processing)版本和SMP(Symmetric Multi-Processing)版本。

SMP版本是多個CPU之間共享相同的內存總線等資源,一般只能在單機上運行,受單機CPU性能及CPU核數限制。MPP版本是每個CPU有獨享的內存總線等資源,CPU之間通過網絡通信交換信息,可以在計算機集群上進行計算,大幅提升計算速度。

單機和多機計算背后的詳細原理和意義在《EDA云實證Vol.7:揭秘20000個VCS任務背后的“搬桌子”系列故事》里解釋得非常清楚。

雖然應用不同,原理是一樣的。

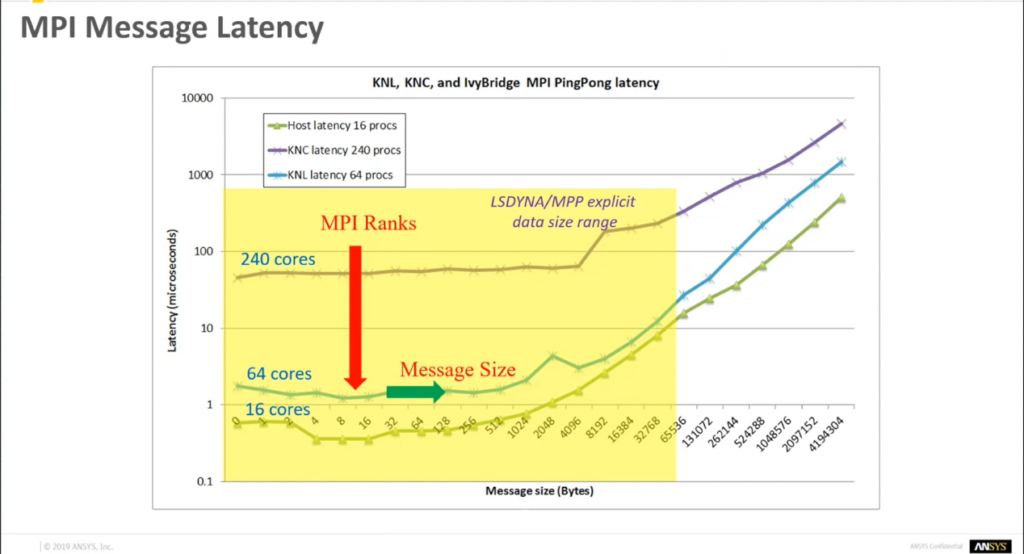

和Fluent一樣,隨著計算節點規模地增加,LS-DYNA有很明顯的節點之間數據交換造成的通信開銷,造成信息延時。可以回顧一下《CAE云實證Vol.5:怎么把需要45天的突發性Fluent仿真計算縮短到4天之內?》

下圖這張PingPong測試(顧名思義就是找一個數據包不斷地在兩個節點之間丟來丟去,像打乒乓球一樣。)能看出從16 cores到240 cores,隨著核數增加,信息延時顯著高出一個數量級。而隨著通信數據增加到一定程度,信息延時會出現爆發性增長。

為了充分解答用戶的疑惑,我們選擇了不同類型,不同代際與不同規模的云資源,分別做了以下場景的驗證。

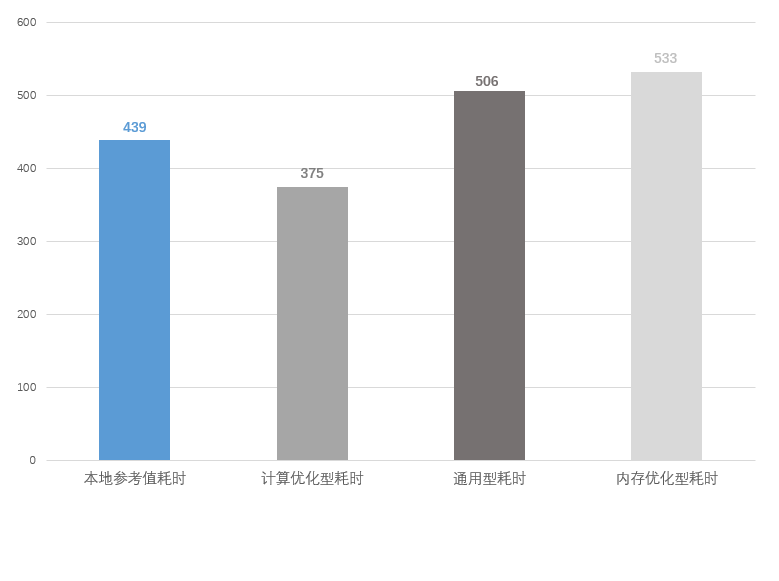

實證場景一:不同類型配置

本地 VS 云端計算優化型實例 VS 云端通用型實例 VS 云端內存優化型實例

結論:

1、同等核數下,云端計算優化型實例的表現優于通用型實例、內存優化型實例和本地計算資源;

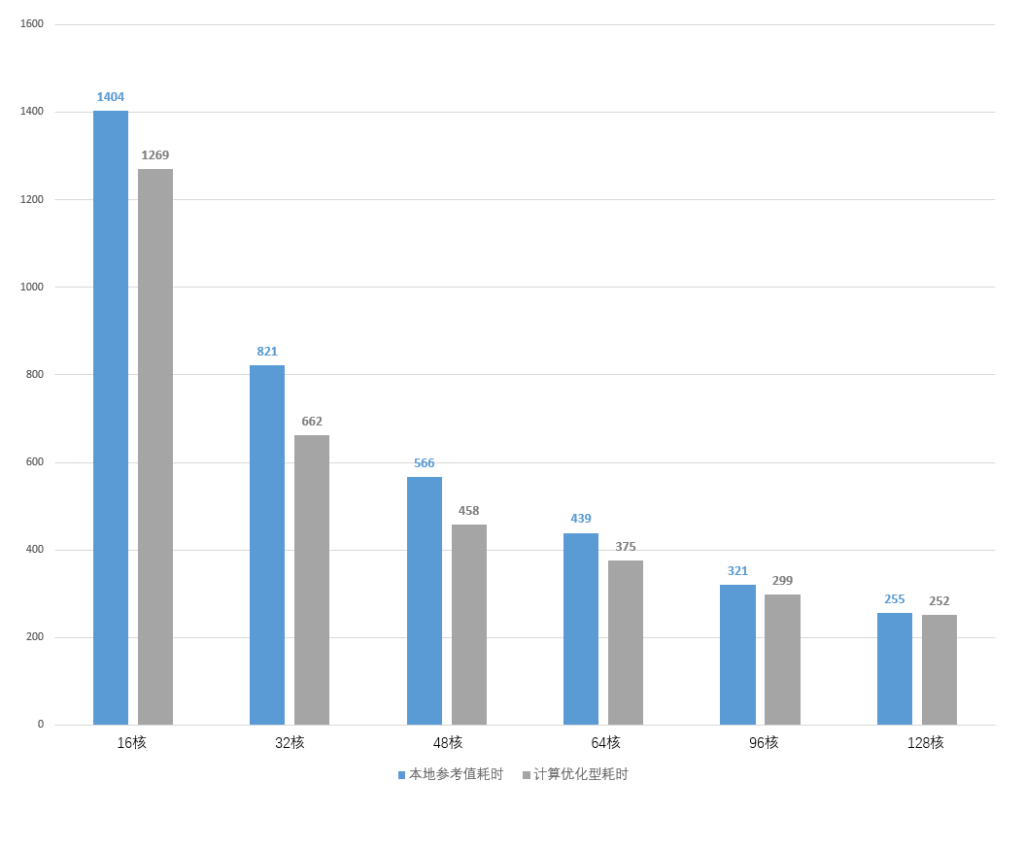

2、隨著核數的上升,由于節點間通信開銷指數級上升,性能的提升隨著線程數增長逐漸變緩。當核數增加到128核后,云端計算優化型實例與本地資源運行相同LS-DYNA所需的時間相差無幾。

實證過程:

1、本地使用64核計算資源運算一組LS-DYNA任務,耗時439分鐘;

2、云端調度64核計算優化型實例運算一組LS-DYNA任務,耗時375分鐘;

3、云端調度64核通用型實例運算一組LS-DYNA任務,耗時506分鐘;

4、云端調度64核內存優化型實例運算一組LS-DYNA任務,耗時533分鐘;

5、本地分別使用16、32、48、64、96、128核計算資源運算同一組LS-DYNA任務,耗時分別為1404、821、566、439、321、255分鐘;

6、云端分別調度16、32、48、64、96、128核計算優化型實例運算同一組LS-DYNA任務,耗時分別為1269、662、458、375、299、252分鐘。

可以看到當核數較少時,計算優化型實例的耗時要明顯少于本地資源,但隨著核數的增加,兩者的耗時逐漸接近,尤其是在128核時,計算優化型實例幾乎已經喪失了所有的優勢。

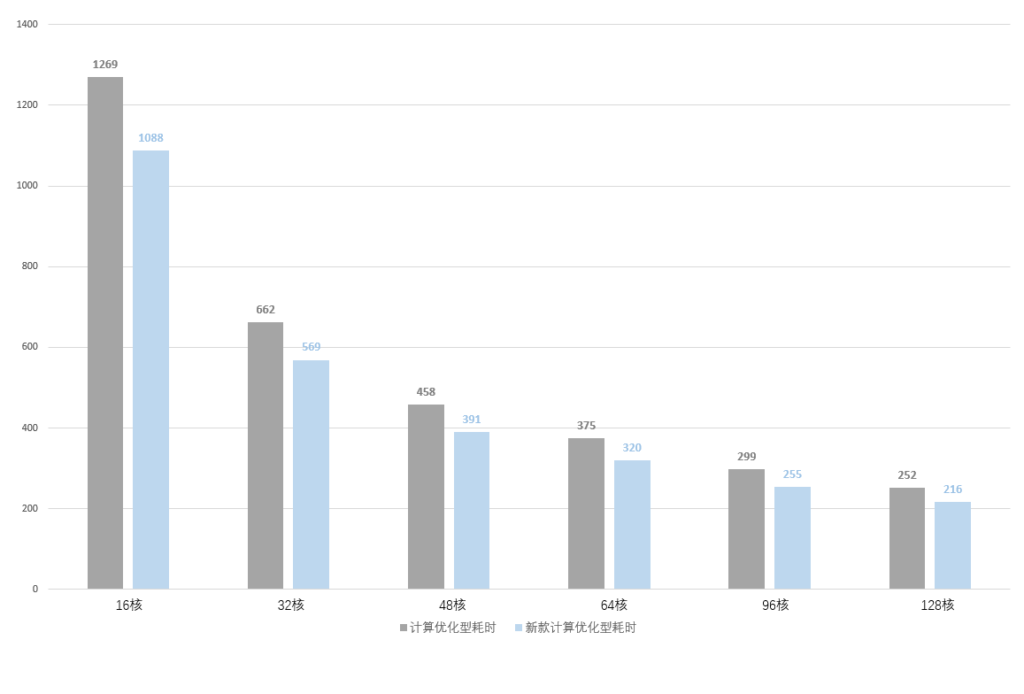

實證場景二:不同代際,同樣類型配置

本地 VS 云端計算優化型實例 VS 新一代云端計算優化型實例

結論:

新款計算優化型實例運算效率相比舊款提升約15%,且價格更便宜,但同樣存在線性不足的問題。

實證過程:

1、本地分別使用16、32、48、64、96、128核計算資源運算同一組LS-DYNA任務,耗時分別為1404、821、566、439、321、255分鐘;

2、云端分別調度16、32、48、64、96、128核計算優化型實例運算同一組LS-DYNA任務,耗時分別為1269、662、458、375、299、252分鐘;

3、云端分別調度16、32、48、64、96、128核新款計算優化型實例運算同一組LS-DYNA任務,耗時分別為1088、569、391、320、255、216分鐘。

新款計算優化型實例無論是在低核數還是高核數下相比老款均有約15%的性能提升。

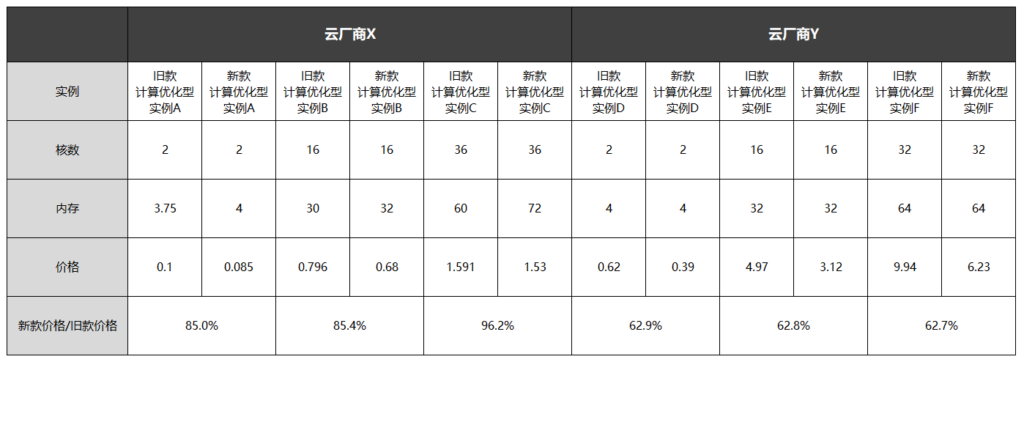

那么價格又如何呢?

我們來感受一下不同云廠商多款計算優化型實例的價格差異:

在同等規格下,新款的價格普遍要比舊款便宜,最低甚至接近六折。

當然,并不是所有的云端新款實例都比舊款又快又便宜。

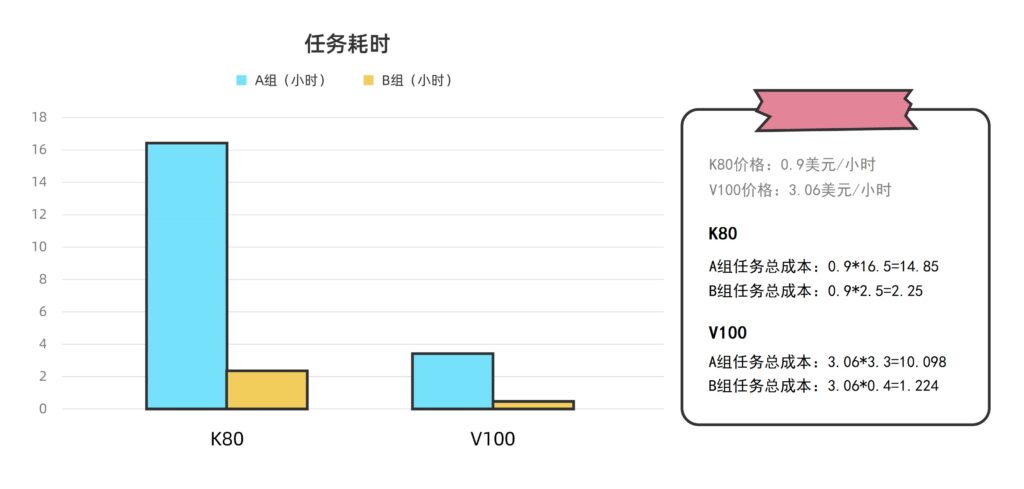

比如我們之前在運算Amber任務時,NVIDIA Tesla K80(2014年上市)的耗時是V100(2017年上市)的約5-6倍,價格卻只有后者的三分之一。

這種時候,我們必須在時間和金錢之間做出一些取舍。詳細可以看這里《生信云實證Vol.6:155個GPU!多云場景下的Amber自由能計算》

我們有一份六大公有云廠商云服務器資源價格全方位對比報告,幫助你對主流廠商的資源價格了如指掌:《六家云廠商價格比較:AWS/阿里云/Azure/Google Cloud/華為云/騰訊云》

同為計算優化型實例,不管新款舊款,都沒有解決LS-DYNA任務大規模并行計算不線性問題。

這個問題的解決方案在哪里?

我們看下一個場景:

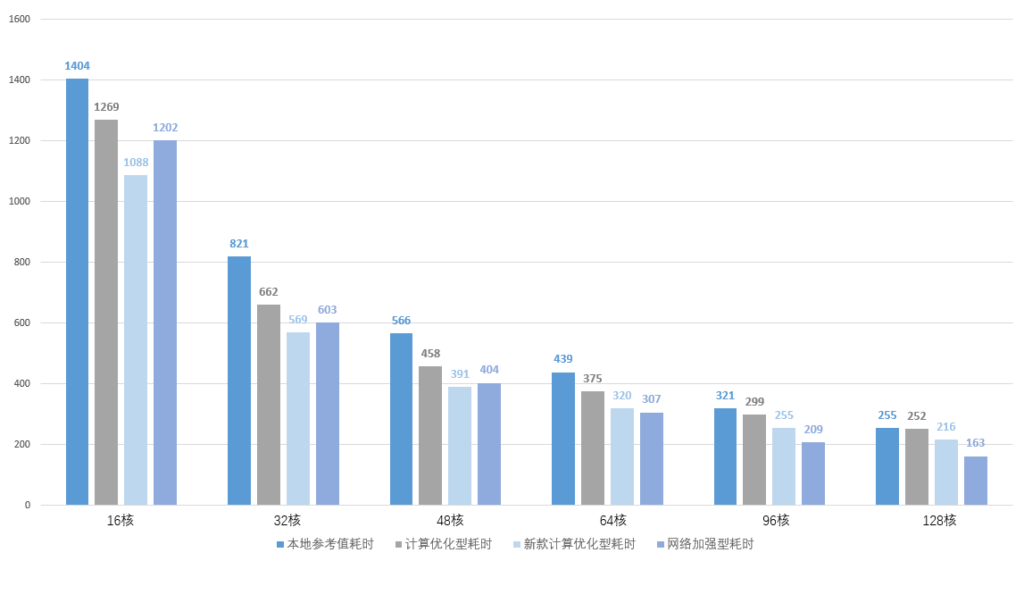

實證場景三:不同規模云端擴展性驗證

本地 VS 云端計算優化型實例 VS 云端網絡加強型實例

結論:

1、在云端使用網絡加強型實例,調度128核計算資源,最多可將運算一組LS-DYNA任務的耗時縮短到135分鐘,只有本地資源和云端計算優化型實例耗時的約二分之一;

2、網絡加強型實例有效解決了LS-DYNA任務并行計算節點間通信問題,在云上展現了良好的線性擴展性。

實證過程:

1、本地分別使用16、32、48、64、96、128核計算資源運算同一組LS-DYNA任務,耗時分別為1404、821、566、439、321、255分鐘;

2、云端分別調度16、32、48、64、96、128核計算優化型實例運算同一組LS-DYNA任務,耗時分別為1269、662、458、375、299、252分鐘;

3、云端分別調度16、32、48、64、96、128核新款計算優化型實例運算同一組LS-DYNA任務,耗時分別為1088、569、391、320、255、216分鐘;

4、云端分別調度16、32、48、64、96、128核網絡加強型實例運算同一組LS-DYNA任務,耗時分別為1202、603、404、307、209、163分鐘。

從上表中可以明顯地觀察到,網絡加強型實例雖然在低核數下的表現并不起眼,但隨著核數的增加,性能提升幅度相當大,在128核的環境下相比本地資源的性能提升將近一倍,線性表現堪稱完美。

在之前的Fluent實證中,我們也驗證了這一點。

用戶的原有使用習慣需不需要改變呢?

在Fluent實證里,我們的切入角度是任務提交方法:

通過journal標準流程化 VS Fluent應用圖形界面兩種模式,適配不同基礎的用戶類型。

這次我們換一個角度——數據傳輸方法和習慣。

用戶在本地:

不論是單機模式還是使用服務器集群,用戶只需要把數據傳到本地機器或服務器上,便可以直接跑任務,當然后面可能有IT部門會完成服務器端數據管理工作。

用戶自己使用云:

用戶將數據傳到本地機器或服務器之后,還需要在云端開啟資源、搭建環境,手動進行數據的上傳和下載。

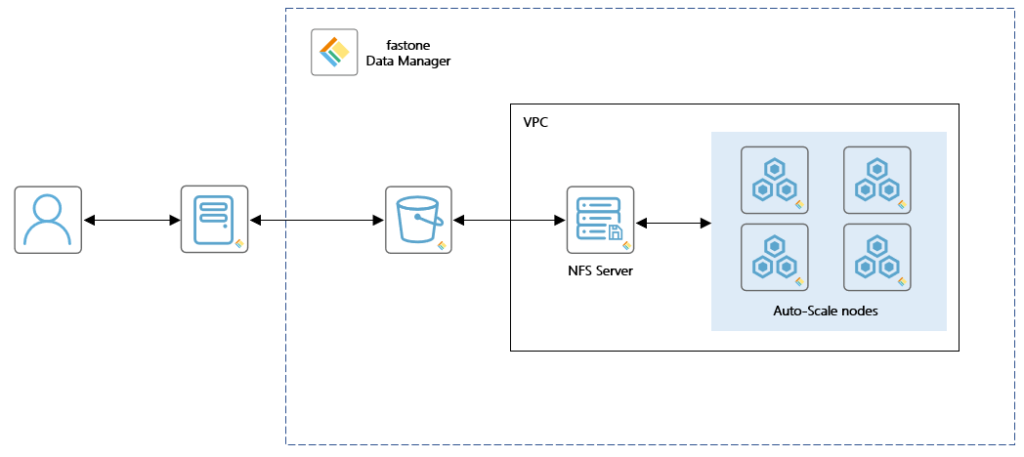

用戶使用我們平臺:

和本地一樣,用戶只需要把數據上傳到我們的DM(Data Manager)工具上,就可以直接使用數據來跑任務了。

手動模式和自動模式的巨大差異,可以見這篇《EDA云實證Vol.1:從30天到17小時,如何讓HSPICE仿真效率提升42倍?》

對于用戶而言,使用我們的DM工具至少有三大優勢:

1、自動關聯集群,不改變操作習慣

用戶無需在多套認證系統之間切換,使用統一的身份認證即可傳輸數據,并自動關聯云端集群進行計算,不改變其原有的使用習慣。

2、一次上傳,多次使用

數據只需上傳一次即可多次使用,其他用戶在經過統一認證后也可隨時共享,極大提升團隊協同能力。

3、大幅提升傳輸效率

關于這點,我們在這篇《CAE云實證Vol.2:從4天到1.75小時,如何讓Bladed仿真效率提升55倍?》里有提到,用戶在跑Bladed任務之前需要上傳多達數百GiB的風文件。

而且,隨著任務的調整,有大量小文件需要增量上傳。在這個實證中,用戶需要上傳9600個任務文件,每個幾十MiB不等。

我們的DM工具能很好地滿足用戶需求,支持全自動化數據上傳,可充分利用帶寬,幫助用戶快速上傳、下載海量數據。

同時,利用fastone自主研發的分段上傳、高并發、斷點續傳等數據傳輸技術,優化海量數據的傳輸效率。

實證小結

1、LS-DYNA任務能夠在云端有效運行,大幅提升求解效率;

2、匹配合適類型云資源,LS-DYNA應用的高效率并行性在云端同樣適用;

3、fastone的DM工具為用戶提供了簡單有效的云端數據傳輸方案,同時無需改變用戶本地使用習慣;

4、fastone能有效進行資源的統一管理和監控。

本次CAE行業云實證系列Vol.8就到這里了。

下一期的CAE云實證,我們聊COMSOL。

請保持關注哦!

- END -

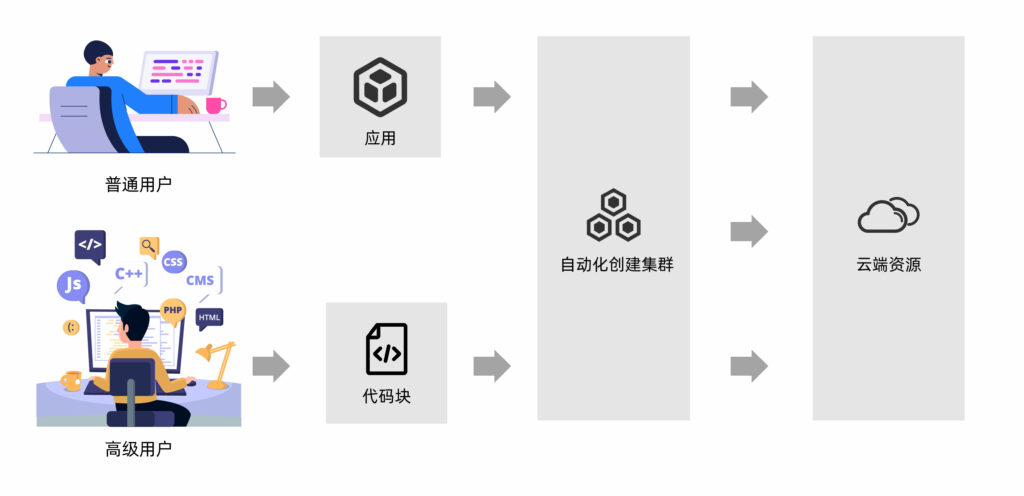

我們有個為應用定義的計算云平臺

集成多種應用,大量任務多節點并行

應對短時間爆發性需求,連網即用

跑任務快,原來幾個月甚至幾年,現在只需幾小時

5分鐘快速上手,拖拉點選可視化界面,無需代碼

支持高級用戶直接在云端創建集群

掃碼免費試用,送200元體驗金,入股不虧~

更多電子書

歡迎掃碼關注小F(ID:imfastone)獲取

你也許想了解具體的落地場景:

揭秘20000個VCS任務背后的“搬桌子”系列故事

155個GPU!多云場景下的Amber自由能計算

怎么把需要45天的突發性Fluent仿真計算縮短到4天之內?

5000核大規模OPC上云,效率提升53倍

提速2920倍!用AutoDock Vina對接2800萬個分子

從4天到1.75小時,如何讓Bladed仿真效率提升55倍?

從30天到17小時,如何讓HSPICE仿真效率提升42倍?

關于為應用定義的云平臺:

2小時,賬單47萬!「Milkie Way公司破產未遂事件」復盤分析

高情商:人類世界模擬器是真的!低情商:你是假的……

【2021版】全球44家頂尖藥企AI輔助藥物研發行動白皮書

EDA云平臺49問

國內超算發展近40年,終于遇到了一個像樣的對手

幫助CXO解惑上云成本的迷思,看這篇就夠了

花費4小時5500美元,速石科技躋身全球超算TOP500

Fluent算得上應用最廣泛的CFD應用了。2006年5月,正式成為Ansys大家庭中的重要成員,共享先進的Ansys公共CAE技術。

數值計算方法有幾個難點:

1、很大程度上依賴于經驗與技巧;

2、數值處理方法可能導致計算結果不真實;

3、因為涉及大量數學計算,有很高的計算資源需求。隨著應用的物理建模不斷精細,數值模擬分辨率越來越高,對計算能力的要求也越來越高。

當求解問題規模越來越大,網格數上升到幾千萬甚至上億的時候,如何讓Fluent仿真任務在更短的時間迭代收斂呢?

面對永無止境的計算需求,我們主要發揮作用就在第三點上。

今天我們通過一個實證來看看具體怎么實現。

用戶需求

某高校實驗室使用Ansys Fluent進行基于化學反應模型的CFD流體仿真,因科研項目需要結題,需要在一周內完成10多個case的運算。

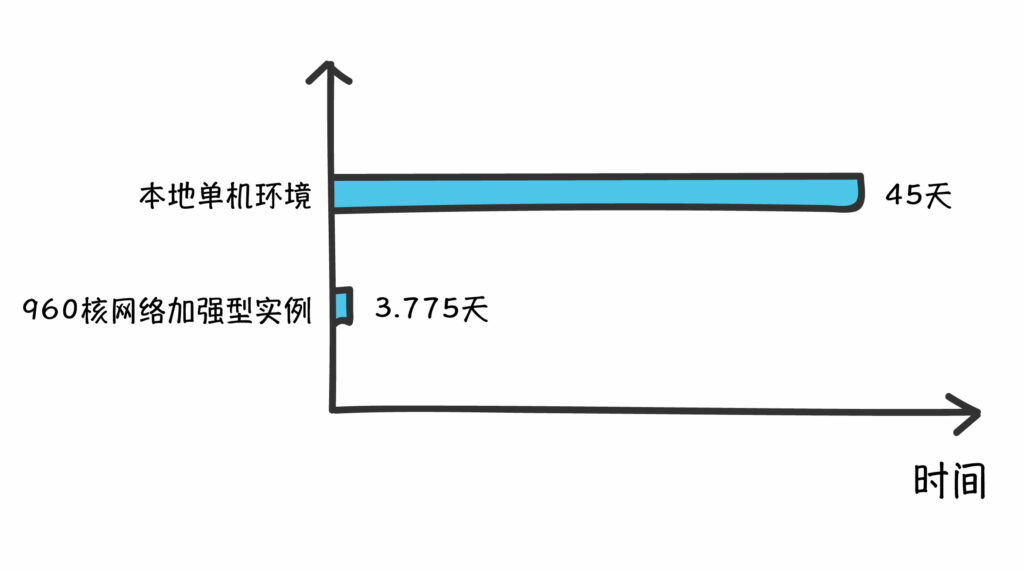

該實驗室有80核本地資源,通常情況都是單機跑,沒有集群環境。根據以往經驗推斷,要完成這組任務需要花費至少45天才能完成。

實驗室老師也考慮過使用超算。

但一方面,超算的使用門檻比較高,且應用需要用戶配置,無法做到開箱即用,他們更習慣拖拉曳的圖形界面操作方式。

另一方面,該實驗室迫切需要能夠在短時間內使用比較大規模的算力資源,而超算沒這么快,需要等。

我們從整體規模、使用體驗、計費方式、商用門檻、更新周期、合作生態、云端支持七個角度對超算和云計算進行了全方位的對比,有興趣可以看一下《國內超算發展近40年,終于遇到了一個像樣的對手》

實證目標

1、Fluent任務能否在云端有效運行?

2、fastone能夠短時間內獲取大量算力資源,大幅度縮短項目周期?

3、Fluent應用的高效率并行性是否在云端同樣適用?

4、針對擅長和不擅長編程的用戶,fastone能否提供不同的操作方式?

5、fastone平臺能否支持實時查看殘差圖?

實證參數

平臺:

fastone企業版產品

應用:

Ansys Fluent 20.20

操作系統:

CentOS 7.6

適用場景:

油/氣能量的產生和環境應用

航天和渦輪機械的應用

汽車工業的應用

熱交換應用

電子/HVAC應用

材料處理應用

建筑設計和火災研究

云端硬件配置:

Ansys Fluent一直宣稱自己支持高效率的并行計算功能,在2016年曾聯手CRAY和HLRS超算創了一項世界記錄,將Fluent擴展到超過172,000個計算機核心。

對于以有限單元法為基礎的CFD類計算,尤其是選用隱式格式和耦合算法的時候,并行計算時會將網格分成很多塊放在不同的計算節點上,在計算時每個迭代步節點之間需要進行大量的數據交換。因此,節點之間的數據通信就顯得尤為重要。

Fluent通過內置MPI并行機制來大幅度提高可擴展性,通過放大計算資源規模來最短時間給出高精度的計算結果。

而在本地或超算環境,比較有效的解決方案就是IB-Infiniband。

針對這一特性,我們分別在云端選擇了計算優化型實例和網絡加強型實例進行驗證。

調度器:

Fluent原生只支持LSF/SGE/PBS調度器,平臺通過Slurm Wrapper的方式都可以支持。

關于這一點,下次再細講。

這篇文章《億萬打工人的夢:16萬個CPU隨你用》里,我們基于這四家主流調度器:LSF/SGE/Slurm/PBS以及它們的9個演化版本進行了梳理和盤點。

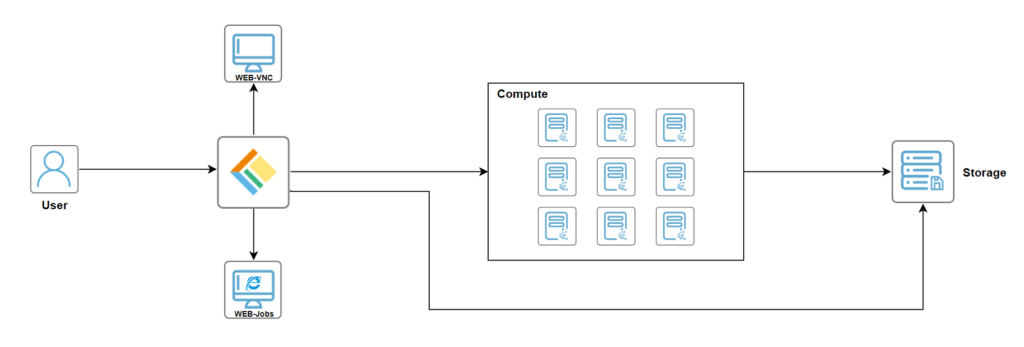

技術架構圖:

實證場景一

云端擴展性驗證

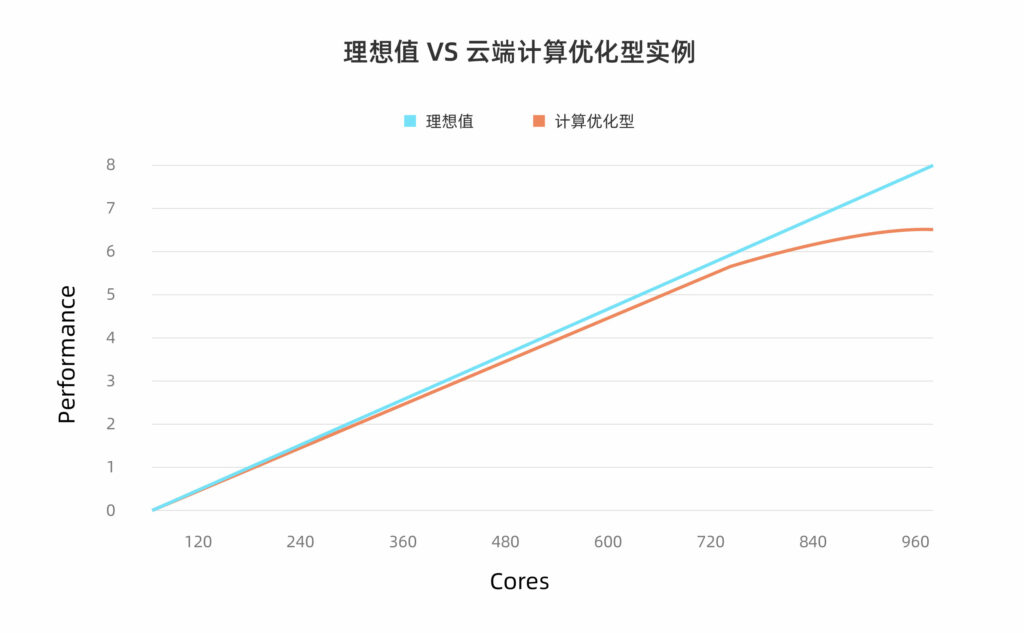

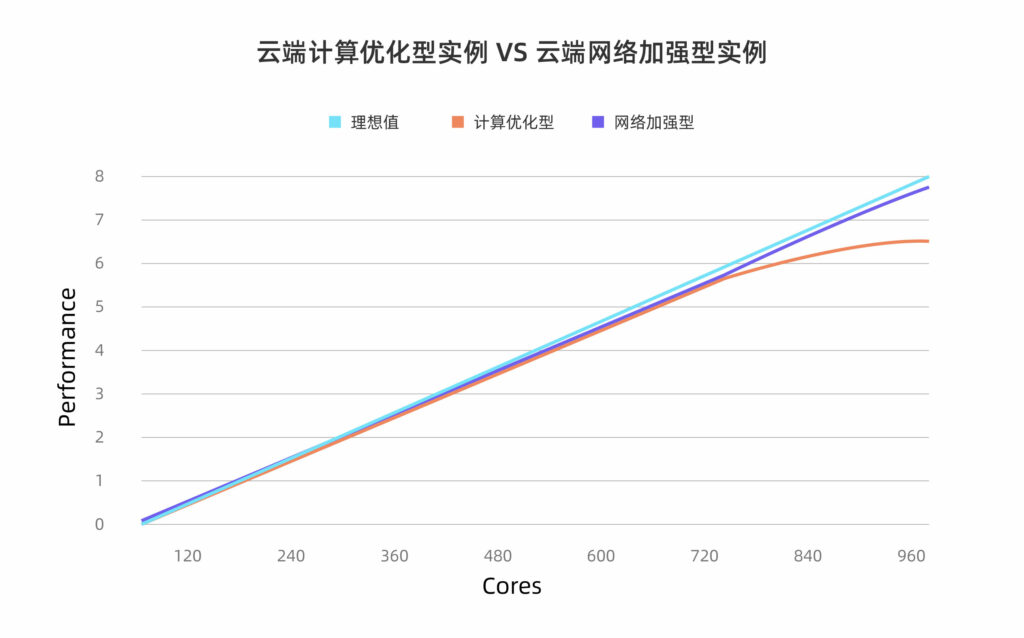

理想值 VS 云端計算優化型實例

結論:

1、在云端使用計算優化型實例,當所調度資源在480核及以下時,云端擴展性較好。

2、隨著核數逐漸增加,由于節點間通信開銷指數級上升,性能的提升隨著線程數增長逐漸變緩。當核數增加到960核時,計算優化型實例共耗時106.6小時,比理想耗時高16.6小時。

實證過程:

1、云端調度120核計算優化型實例運算一組Fluent任務,耗時721.8小時;

2、云端調度240核計算優化型實例運算一組Fluent任務,耗時362.2小時;

3、云端調度360核計算優化型實例運算一組Fluent任務,耗時242.4小時;

4、云端調度480核計算優化型實例運算一組Fluent任務,耗時183.3小時;

5、云端調度600核計算優化型實例運算一組Fluent任務,耗時152.1小時;

6、云端調度720核計算優化型實例運算一組Fluent任務,耗時130.8小時;

7、云端調度840核計算優化型實例運算一組Fluent任務,耗時117.3小時;

8、云端調度960核計算優化型實例運算一組Fluent任務,耗時106.6小時。

實證場景二

云端擴展性驗證

云端計算優化型實例 VS 云端網絡加強型實例

結論:

1、在云端使用云端網絡加強型實例,調度960核計算資源,最多可將運算一組Fluent任務的耗時從本地單機環境的45天縮短到90.6小時(3.775天),可滿足該實驗室“一周內完成”的要求;

2、網絡加強型實例有效解決了Fluent任務并行計算節點間通信問題,在云上展現出了良好的線性擴展性。在相同的核數下,網絡加強型實例的線性十分接近理想值。也就是說,如果核數增加,仿真所需時間會成比例縮短。

實證過程:

1、云端調度120核網絡加強型實例運算一組Fluent任務,耗時720.1小時;

2、云端調度240核網絡加強型實例運算一組Fluent任務,耗時360.3小時;

3、云端調度360核網絡加強型實例運算一組Fluent任務,耗時240.2小時;

4、云端調度480核網絡加強型實例運算一組Fluent任務,耗時180.2小時;

5、云端調度600核網絡加強型實例運算一組Fluent任務,耗時144.4小時;

6、云端調度720核網絡加強型實例運算一組Fluent任務,耗時121.1小時;

7、云端調度840核網絡加強型實例運算一組Fluent任務,耗時103.3小時;

8、云端調度960核網絡加強型實例運算一組Fluent任務,耗時90.6小時。

實證場景三

任務提交方法

journal標準流程化模式 VS Fluent應用圖形界面模式

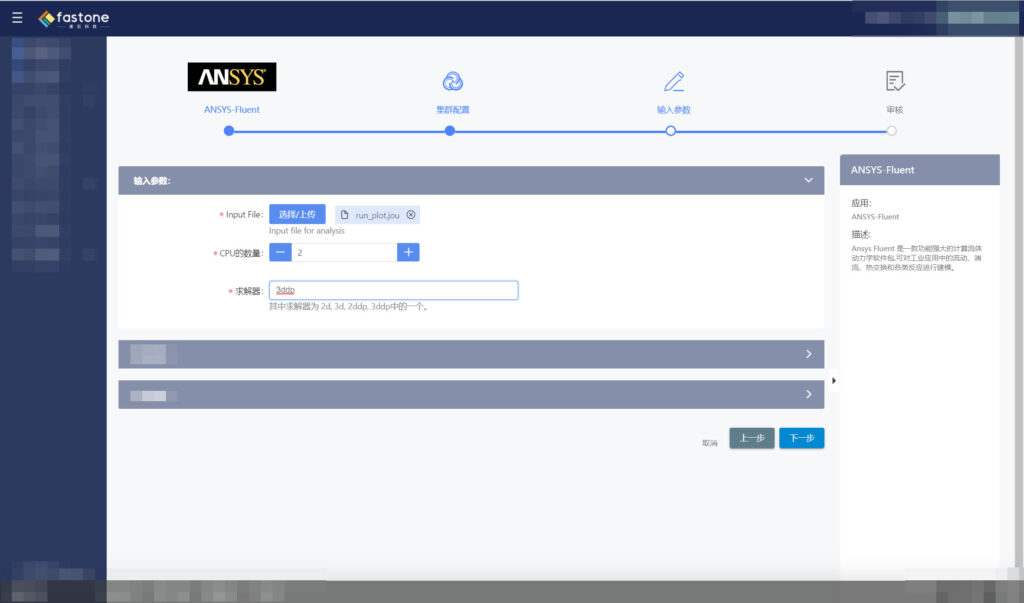

我們為有編程基礎的用戶提供journal標準流程化模式,用戶可在Web瀏覽器中直接提交已編寫好的journal文件,開啟云端Fluent任務,方便快捷。

而對于無編程基礎的用戶提供Fluent應用圖形界面模式,用戶可通過Web瀏覽器啟動集群,跳轉到虛擬桌面,并可在該桌面直接操作Fluent應用進行相應設置以開啟云端Fluent任務。

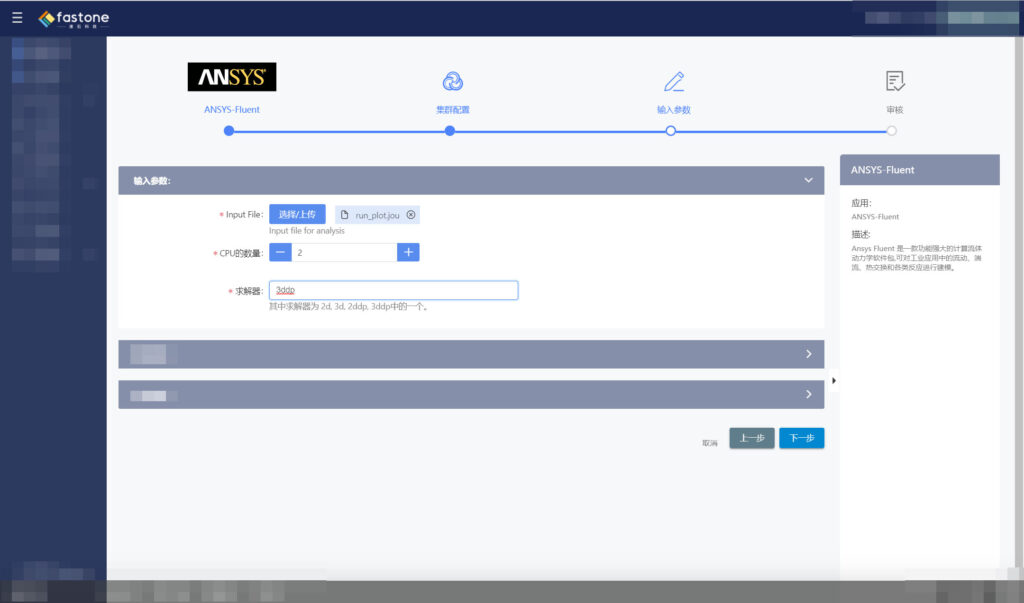

journal標準流程化模式分為三個步驟

1、通過Web瀏覽器登錄fastone平臺;

2、在Web界面新建任務、選擇應用、配置資源;

3、在應用中選擇journal文件(即Fluent腳本文件),輸入所需資源和應用參數(如求解器精度),提交任務。

該種方式要求用戶有能力自定義journal文件,即需要用戶具有一定的編程基礎。由于該高校科研組缺乏相應編程能力,fastone為其提供了Fluent應用圖形界面提交方式。

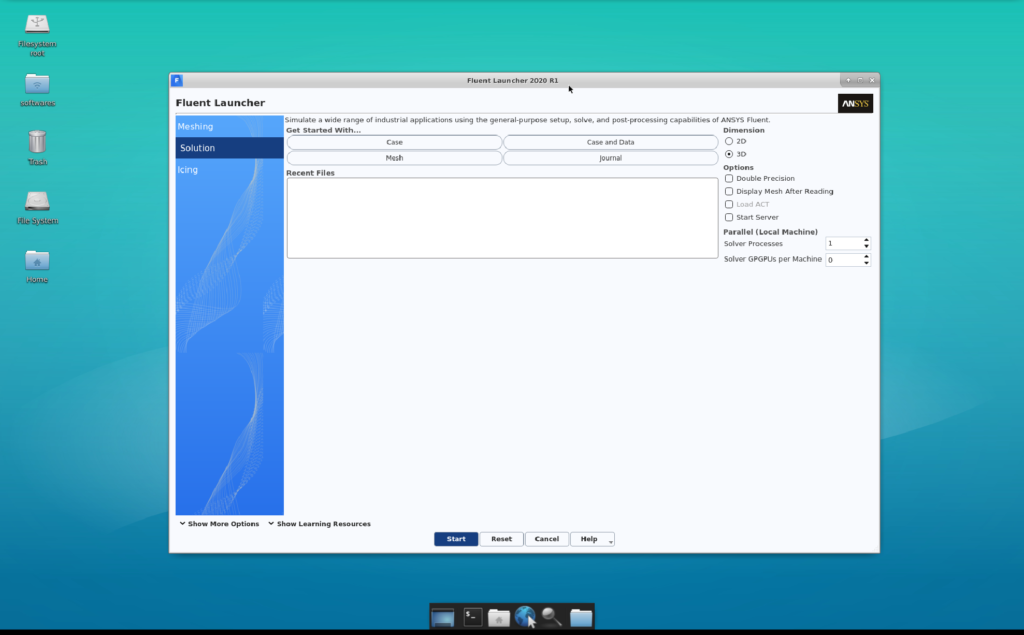

Fluent應用圖形界面模式有四個步驟

1、通過Web瀏覽器登錄fastone平臺;

2、在Web界面新建集群、配置資源;

3、在已創建的集群點擊WebVNC遠程桌面圖標(同時提供WebSSH遠程命令行功能);

4、跳轉到虛擬桌面,可在該桌面直接操作Fluent應用進行相應設置以提交任務。該種方式模擬出了Fluent的原生界面,用戶更為熟悉操作環境,使用體驗較好。

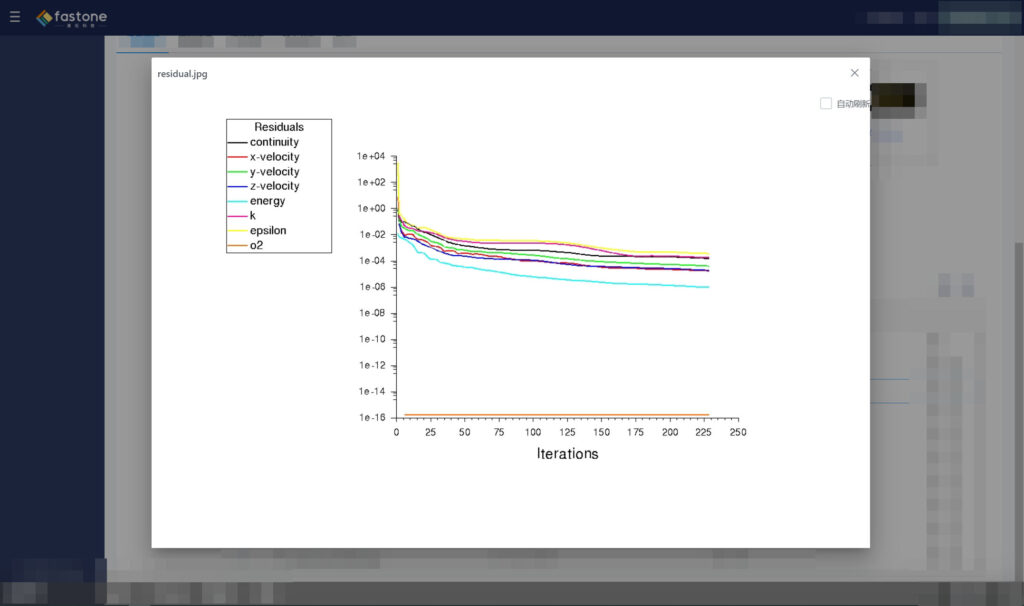

平臺還支持實時查看殘差曲線,監控計算的收斂情況。

實證場景四

用戶模式

普通用戶模式 VS 高級用戶模式

上一個場景里的journal標準流程化模式就是通過Web瀏覽器選擇新建任務、選擇應用、上傳文件,輸入參數,配置資源等一系列向導式路徑提交任務。

而對于高級用戶,比如本身對應用工作流的理解和編程能力超強,可以不用走普通用戶通過應用向導式提交的路徑,可以直接根據自己寫的腳本,通過Web瀏覽器選擇新建集群,然后按需動態地在云端創建HPC集群。

關于我們在云端部署自動化模式VS傳統手動模式間的巨大差異可查看:EDA云實證Vol.1:從30天到17小時,如何讓HSPICE仿真效率提升42倍?

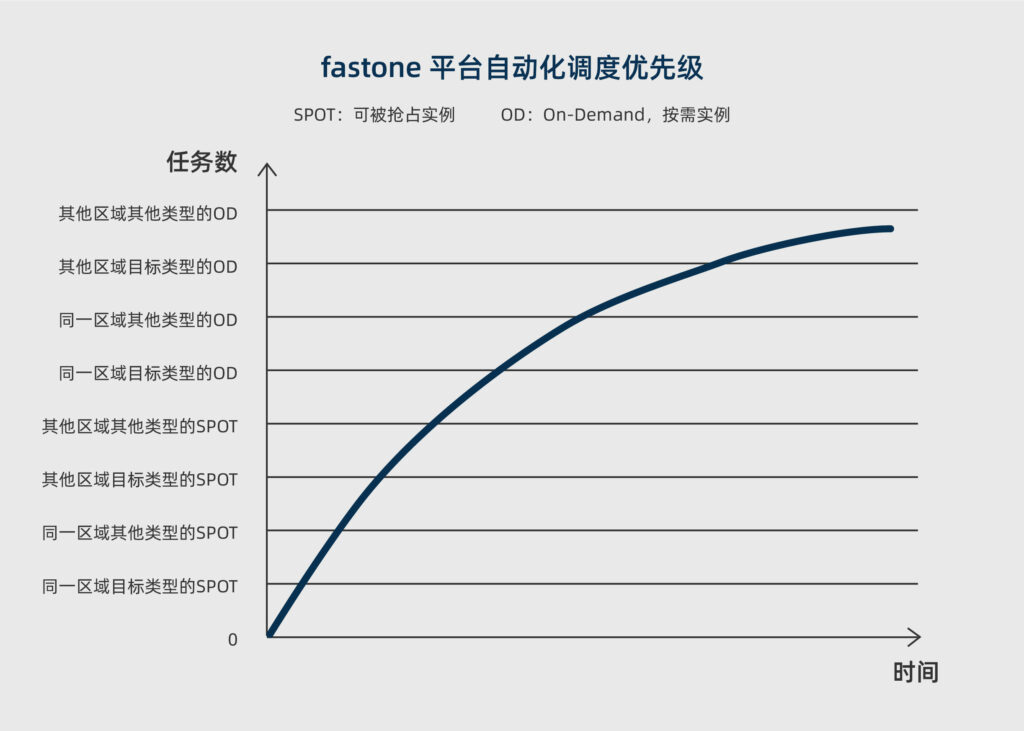

關于我們的Auto-Scale功能自動監控用戶提交的任務數量和資源的需求,動態按需地開啟所需算力資源,在不夠的時候,還能根據不同的用戶策略,自動化調度本區域及其他區域的目標類型或相似類型實例資源,看這篇:生信云實證Vol.3:提速2920倍!用AutoDock Vina對接2800萬個分子

實證小結

1、Fluent任務能夠在云端有效運行;

2、fastone能夠快速獲取大量云端算力,大幅縮短項目周期;

3、針對Fluent應用對節點間數據通信的高要求,選擇網絡加強型實例可以在云端達到很好的高效率并行性;

4、針對不同的用戶,fastone提供多種任務提交方式以供選擇,既支持journal標準流程化模式,也支持Fluent應用圖形界面模式;

5、fastone平臺支持實時查看殘差圖;

6、高級用戶可以根據自定義腳本,直接在云端創建HPC集群。

本次CAE行業Cloud HPC實證系列Vol.5就到這里了。

在下一期的CAE云實證中,我們將利用速石平臺使LS-DYNA模擬性能得到極大提升。

未來我們還會帶給大家更多領域的用云“真香”實證,請保持關注哦!

- END -

2分鐘自動開通,即刻獲得TOP500超級算力

點擊下圖立即體驗

2020年新版《六大云廠商資源價格對比工具包》

添加小F微信(ID: imfastone)獲取

你也許想了解具體的落地場景:

EDA云實證Vol.4:5000核大規模OPC上云,效率提升53倍

生信云實證Vol.3:提速2920倍!用AutoDock Vina對接2800萬個分子

CAE云實證Vol.2:從4天到1.75小時,如何讓Bladed仿真效率提升55倍?

EDA云實證Vol.1:從30天到17小時,如何讓HSPICE仿真效率提升42倍?

關于云端高性能計算平臺:

國內超算發展近40年,終于遇到了一個像樣的對手

幫助CXO解惑上云成本的迷思,看這篇就夠了

靈魂畫師,在線科普多云平臺/CMP云管平臺/中間件/虛擬化/容器是個啥

花費4小時5500美元,速石科技躋身全球超算TOP500