說起多物理場仿真,必然繞不開COMSOL Multiphysics。

不局限于究竟是哪種物理場,不局限于物理場之間如何實現耦合。COMSOL提供統一的數值仿真平臺,使用相同的操作界面和工作流進行不同類型的數值仿真,可以說十分優秀了。

從1998年發布首個版本至今,COMSOL一直在持續進化,如今它已經有了30多個針對不同應用領域的專業模塊,涵蓋力學、電磁場、流體、傳熱、化工、MEMS、聲學等專業學科,并可以將不同的物理問題關聯起來,方便研究不同物理過程之間的相互作用。

越來越多Nature、Science及其子刊論文都用到了COMSOL模擬。

今天我們以一個高校用戶為例,講講我們在COMSOL實際運用過程中,除了速度和效率的提升外,還幫他們解決了哪些問題?

比如:

Windows還是Linux?

這是個問題關于多機并行,有多少種不同的打開方式

一旦用了外部資源,比如超算,本地機器閑置了,就問你心不心疼?

本地環境維護,就問你操不操心?

老師的需求:既要,又要,還要,一把滿足,這真實嗎?

……

所以,現在可以發Nature了嗎(劃掉)

用戶需求

某高校課題組有5臺工作站,雖然機器比較老舊,但平時大家協商著劃分時間輪流跑任務,甚至還有排半夜的。整體來說,資源也勉強夠用。

最近該課題組新增了幾名成員,并申請到了幾個科研項目,需要使用COMSOL做大量仿真計算,這就直接導致了計算資源捉襟見肘。

現在的問題點主要有三個:

1、人多了,難管理,資源利用率整體很低;

2、他們也用過超算,但是資源是共享的,有隨時被搶走的風險,心里沒底,而且沒法跟本地連到一起來用;

3、本地的各種維護工作,應用升級,安裝配置等工作非常繁瑣,需要耗費大量時間手工操作。

實證目標

1、COMSOL任務能否在云端跑得更快?

2、fastone平臺的云解決方案能否同時利用好課題組的本地資源?

3、fastone平臺的資源能否提供更大的用戶權限?

4、fastone平臺能否將各種維護工作降到最低?

實證參數

平臺:fastone企業版產品

應用:COMSOL Multiphysics

場景:電磁場分析、風力發電機噪音分析、HVAC導管流線分布等

系統:Windows/Linux

云端配置:計算優化型實例/網絡加強型實例

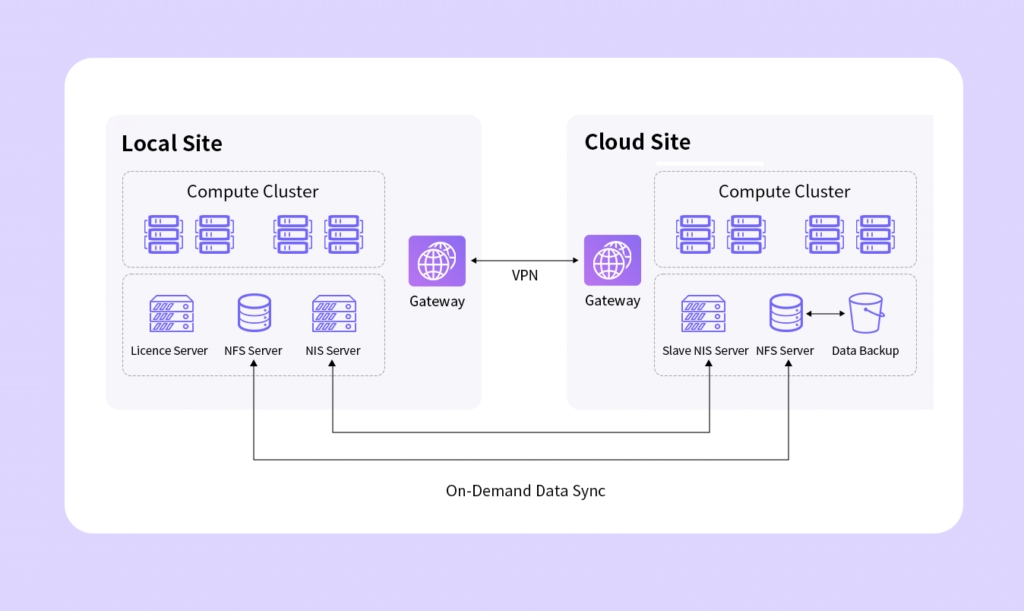

架構圖:

實證過程

一、Windows還是Linux?這是個問題

COMSOL同時支持Windows和Linux系統的集群計算。用戶一直使用的是較為熟悉的Windows版本。

現在,讓我們默念三遍:Windows的世界,一切都要錢的。

單機跑的情況下,這不是什么大問題。但一旦涉及到多機多核運行任務,問題就大了。

比如:主流云廠商對不同操作系統鏡像有不同的定價方式。整體來說,通過Windows系統使用云資源價格比Linux系統要貴。

因此,使用Linux替換Windows也可以有效節省成本。

所有,都要錢。

總之,不是長久之計。

而如何從Windows系統轉換到Linux系統呢?

這就跟習慣了用Android系統的人,換成iOS一樣。一旦適應,操作就如絲般順滑。

為了確保這一點,我們支持用戶在Linux系統中使用圖形化界面操作COMSOL任務,用戶只需熟悉一下Linux的常用操作與工具(如瀏覽器、文本編輯器),即可在很短的時間內上手,操作習慣幾乎無需改變。

而這也為今后用戶在Linux上多機集群化跑COMSOL打下了省錢的基礎。

二、多機并行,不同的打開方式決定了運算效率 根據我們的經驗,COMSOL的情況與Fluent類似。

當核數較低時,性能提升與核數基本成正比;而當云端核數逐漸增加后,由于節點間通信開銷指數級上升,性能的提升會隨著線程數增長逐漸變緩。關于如何解決節點之間數據交換造成的通信開銷問題,可以參考Fluent和LS-DYNA這兩個應用實證:

LS-DYNA求解效率深度測評 │ 六種規模,本地VS云端5種不同硬件配置

怎么把需要45天的突發性Fluent仿真計算縮短到4天之內?

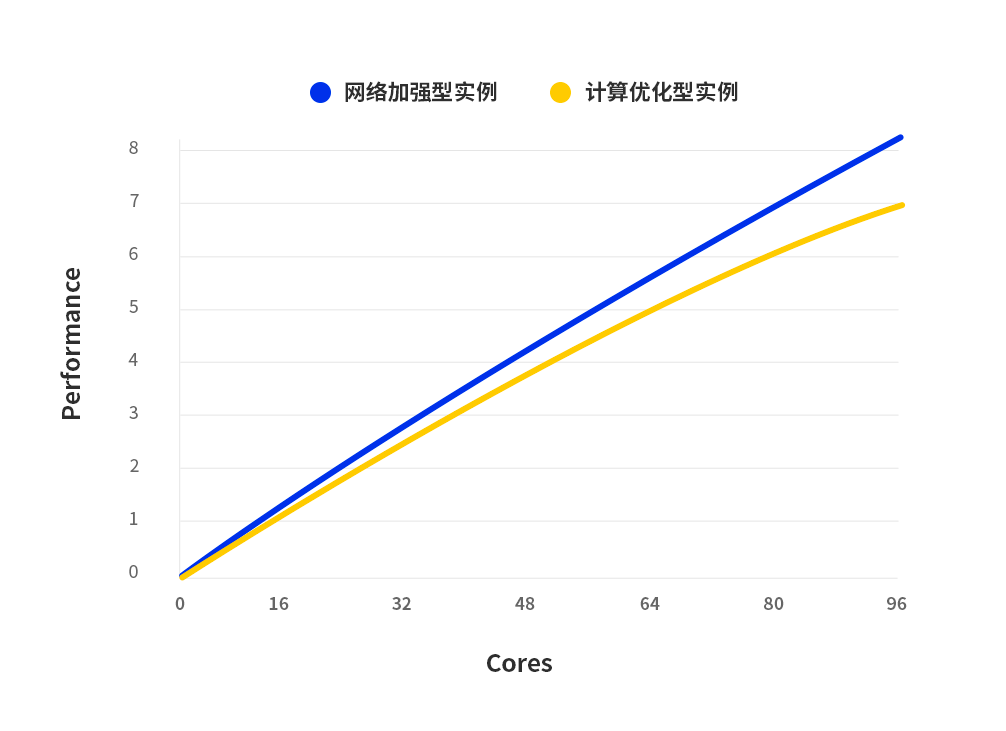

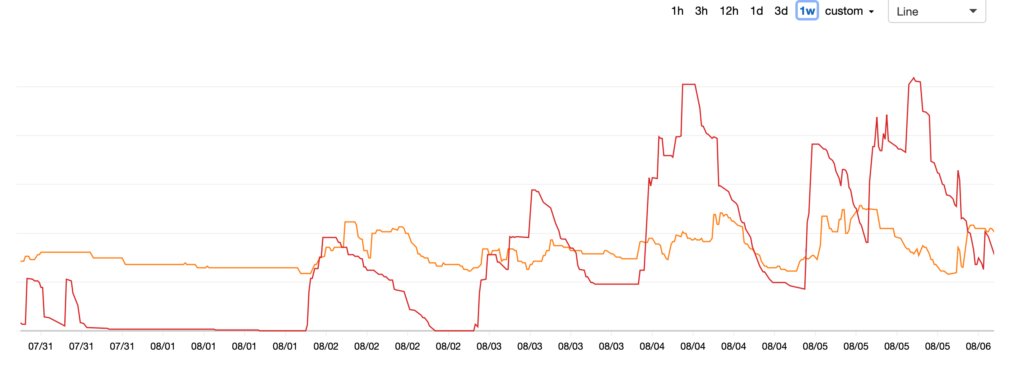

下圖可以看到我們推薦用戶使用的網絡加強型實例對比計算優化型實例的效果。

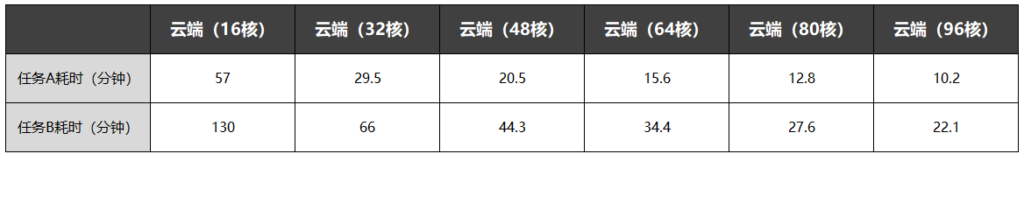

基于Linux系統多機模式計算,在云端使用16-96核不等的計算資源運行兩組COMSOL任務,可以觀察到當計算資源線性增加時,任務耗時呈線性減少。

網絡加強型實例可以有效解決COMSOL任務通信開銷問題。

fastone平臺可以根據用戶需求和任務特性,為用戶推薦最適配的云端配置。

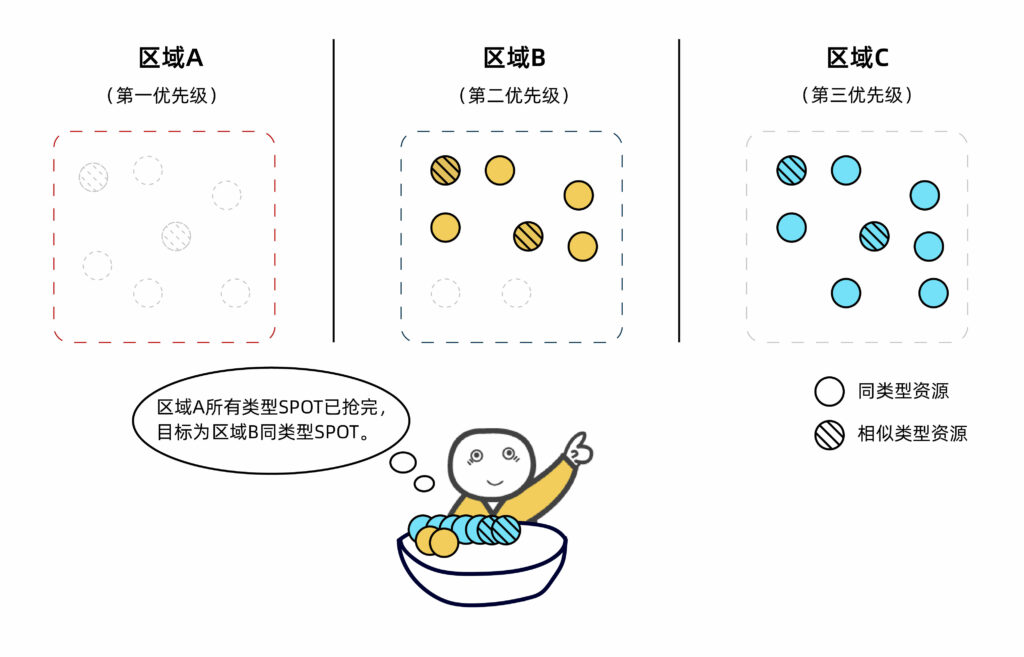

甚至,我們的Auto-Scale功能可以根據不同的用戶策略,比如成本最優還是時間優先,自動化跨區、跨類型為用戶調度云資源,完成計算任務。

至于不同策略具體怎么落地執行?

相比時間優先策略,成本優先怎么做到降低成本最多達67%-90%?

在這篇實證《生信云實證Vol.3:提速2920倍!用AutoDock Vina對接2800萬個分子》里體現得十分明顯。

而即便是比拼單機性能,由于云上機型更新速度快,相比課題組本地老舊的工作站單機性能也提升了超過三分之一。

關于單機和多機計算背后的詳細原理和意義,可以參考VCS應用實證《EDA云實證Vol.7:揭秘20000個VCS任務背后的“搬桌子”系列故事》

云上資源的更新有多快?看這篇《國內超算發展近40年,終于遇到了一個像樣的對手》

三、多人并行又是個什么東西?

多機并行有了,多人并行又是個啥?

如果在本地工作站場景,多人并行就是幾臺機器就是幾個人用唄。使用我們平臺,用戶數量和機器數量不再直接掛鉤。更不用說云端無限資源帶來的幾乎無限的人員擴容空間了。

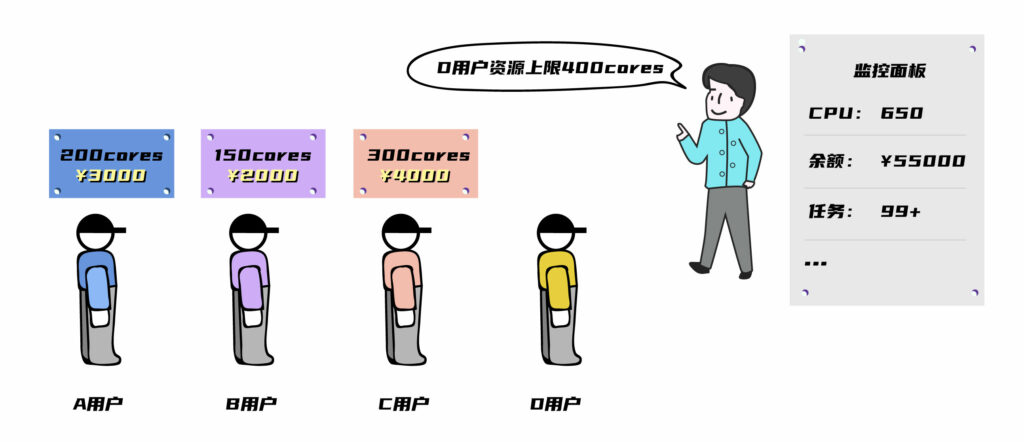

這就不可避免地涉及到了權限和角色管理的問題。fastone平臺的權限和角色管理功能,支持管理員角色對每一個用戶進行相關權限設定,包括預算使用上限和CPU核數使用上限。

多機并行+多人并行,簡單來說就是,要啥有啥。

四、本地云端統一平臺,既不操心,又不心疼,還劃算,還簡單

1、當然是大大優化整體效率。

由于課題組在平臺上跑的應用遠不止COMSOL一種,fastone平臺可對不同應用、不同資源、不同成員的使用情況進行整體監控與評估,并為課題組提供合理化建議,極大地提升了整體效率。

2、本地工作站不再閑置,用滿不心疼

課題組導師覺得放著本地工作站不用簡直就是“浪費”。在獲取外部資源的同時,還是希望能夠將本地的工作站資源給充分利用起來,不然可太心疼了,畢竟當年也是花大價錢買來的。

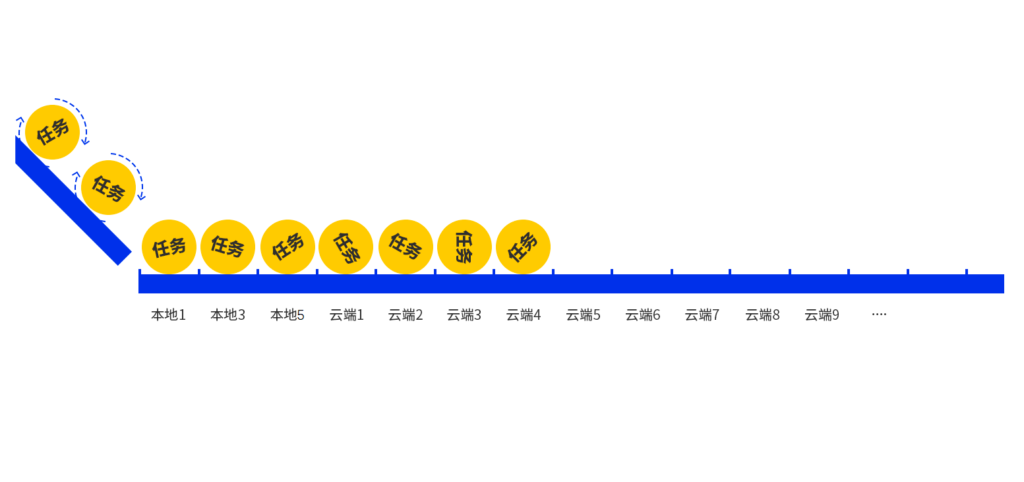

我們為課題組提供了一個混合云平臺。

當用戶處理日常任務時,可以只在本地運行。

而當本地資源不足以應付時,直接自動連接云端海量資源進行運算,操作相當方便,完全不改變用戶的操作習慣。

3、本地軟硬件資源維護,不用操心

課題組的本地環境是需要持續維護的。有老師跟我們吐槽說,一天天地忙著維護環境,整得跟運維工程師一樣了,太耽誤事兒。想找學生幫忙吧,他們很多也不懂啊~老師們的碩博后們也苦不堪言,本專業要學的東西已經多到爆炸,又要理論還要搞實驗,還要學大量計算機專業知識……

我們的云上運行環境都是自動化配置的,不需要人工干預,用戶還可以通過平臺進行統一管理和監控,方便易操作。

五、超算,是完美的解決方案嗎?

1、超算資源是無法與本地資源做成一個整體平臺,統一管理的。所以,既沒有整體監控和管理,又沒有混合云,還沒有自動化維護。

當然,Auto-scale也肯定沒有。

下圖是開啟Auto-Scale功能后,用戶某項目一周之內所調用云端計算資源的動態情況。

2、不同于超算的共享模式,我們提供的是絕對不會被搶走的獨占資源。

這點可太重要了:

1)云資源在任何情況下都不用會被搶走。而超算由于要優先服務國家級科研項目,在某些情況下,即便已經分配到的超算資源,也有可能會被無條件收回;

2)可根據用戶的習慣和應用的特性自由選擇操作系統,沒有任何限制;

3)提供完全開放的管理員權限,應用安裝靈活,且fastone針對市面上常見企業級應用均進行過云原生優化,可隨時提供技術指導;

4)用戶可隨時安裝所需的依賴組件。

5)獨占資源,安全。

關于超算與云計算在整體規模、使用體驗、計費方式、商用門檻、更新周期、合作生態、云端支持等方面的全方位對比,可以掃碼添加小F獲取完整版白皮書。

實證小結

1、fastone平臺完美支持COMSOL的基于不同用戶策略的多機和多人并行,可大大提升任務效率;

2、fastone支持搭建本地云端統一的混合云平臺,完全不浪費本地資源,本地資源不足時自動溢出到云端,操作還簡單,提高整體效率;

3、fastone平臺提供獨占資源,絕不會被搶走,開放管理員權限,安全靈活;

4、fasonte平臺環境完全自動化配置,無需手動維護,省事。

本次CAE行業Cloud HPC實證系列Vol.11就到這里了。下一期的CAE云實證中,我們聊Abaqus。

高效、方便、安全、穩定、省錢……我們對于高校科研的提升遠不止于此,更多有關fastone高校科研云平臺的疑問與解答

請掃描二維碼添加小F微信(ID:imfastone)獲取《這一屆科研計算人趕DDL紅寶書:學生篇/老師篇》

關于fastone云平臺在其他應用上的具體表現,可以點擊以下應用名稱查看:

HSPICE │ Bladed │ Vina │ OPC │ Fluent │ Amber │ VCS │ LS-DYNA │ MOE Virtuoso

- END -

我們有個為應用定義的CAE云仿真平臺

集成多種CAE/CFD應用,大量任務多節點并行

應對短時間爆發性需求,連網即用

跑任務快,原來幾個月甚至幾年,現在只需幾小時

5分鐘快速上手,拖拉點選可視化界面,無需代碼

支持高級用戶直接在云端創建集群

掃碼免費試用,送200元體驗金,入股不虧~

更多電子書

歡迎掃碼關注小F(ID:imfastone)獲取

你也許想了解具體的落地場景:

Auto-Scale這支仙女棒如何大幅提升Virtuoso仿真效率?

1分鐘告訴你用MOE模擬200000個分子要花多少錢

LS-DYNA求解效率深度測評 │ 六種規模,本地VS云端5種不同硬件配置

揭秘20000個VCS任務背后的“搬桌子”系列故事

155個GPU!多云場景下的Amber自由能計算

怎么把需要45天的突發性Fluent仿真計算縮短到4天之內?

5000核大規模OPC上云,效率提升53倍

提速2920倍!用AutoDock Vina對接2800萬個分子

從4天到1.75小時,如何讓Bladed仿真效率提升55倍?

從30天到17小時,如何讓HSPICE仿真效率提升42倍?

關于為應用定義的云平臺:

這一屆科研計算人趕DDL紅寶書:學生篇

楊洋組織的“太空營救”中, 那2小時到底發生了什么?

速石科技獲元禾璞華領投數千萬美元B輪融資

一次搞懂速石科技三大產品:FCC、FCC-E、FCP

速石科技成三星Foundry國內首家SAFE?云合作伙伴

Ansys最新CAE調研報告找到阻礙仿真效率提升的“元兇”

【2021版】全球44家頂尖藥企AI輔助藥物研發行動白皮書

國內超算發展近40年,終于遇到了一個像樣的對手

幫助CXO解惑上云成本的迷思,看這篇就夠了

花費4小時5500美元,速石科技躋身全球超算TOP500