LLM大語(yǔ)言模型的定義

大語(yǔ)言模型(英文:Large Language Model,縮寫LLM),也稱大型語(yǔ)言模型,是一種人工智能模型,旨在理解和生成人類語(yǔ)言。它們?cè)诖罅康奈谋緮?shù)據(jù)上進(jìn)行訓(xùn)練,可以執(zhí)行廣泛的任務(wù),包括文本總結(jié)、翻譯、情感分析等等。LLM的特點(diǎn)是規(guī)模龐大,包含數(shù)十億的參數(shù),幫助它們學(xué)習(xí)語(yǔ)言數(shù)據(jù)中的復(fù)雜模式。這些模型通常基于深度學(xué)習(xí)架構(gòu),如轉(zhuǎn)化器,這有助于它們?cè)诟鞣NNLP任務(wù)上取得令人印象深刻的表現(xiàn)。

LLM到底有多大?

拿 GPT 來(lái)說(shuō), GPT 其實(shí)出現(xiàn)了好幾代,GPT 3 它有 45 個(gè) Tb 的訓(xùn)練數(shù)據(jù),那么整個(gè)維基百科里面的數(shù)據(jù)只相當(dāng)于他訓(xùn)練數(shù)據(jù)的 0. 6%。我們?cè)谶@個(gè)訓(xùn)練的時(shí)候把這個(gè)東西稱作語(yǔ)料,就語(yǔ)言材料,這個(gè)語(yǔ)料的量是可以說(shuō)是集中到我們?nèi)祟愃姓Z(yǔ)言文明的精華在里面,這是一個(gè)非常非常龐大的一個(gè)數(shù)據(jù)庫(kù)。

從量變到質(zhì)變

經(jīng)過(guò)這樣的一個(gè)量的學(xué)習(xí)之后,它產(chǎn)生的一些就是做 AI 的這些計(jì)算機(jī)學(xué)家們,他們沒(méi)有想到會(huì)有這種變化,無(wú)法合理解釋這一現(xiàn)象的產(chǎn)生即——當(dāng)數(shù)據(jù)量超過(guò)某個(gè)臨界點(diǎn)時(shí),模型實(shí)現(xiàn)了顯著的性能提升,并出現(xiàn)了小模型中不存在的能力,比如上下文學(xué)習(xí)(in-context learning)。

這也就催生了兩個(gè)事件:

- 各大AI巨頭提高訓(xùn)練參數(shù)量以期達(dá)到更好的效果

- 由于質(zhì)變?cè)虻臒o(wú)法解釋帶來(lái)的AI安全性考量

LLM涌現(xiàn)的能力

- 上下文學(xué)習(xí)。GPT-3 正式引入了上下文學(xué)習(xí)能力:假設(shè)語(yǔ)言模型已經(jīng)提供了自然語(yǔ)言指令和多個(gè)任務(wù)描述,它可以通過(guò)完成輸入文本的詞序列來(lái)生成測(cè)試實(shí)例的預(yù)期輸出,而無(wú)需額外的訓(xùn)練或梯度更新。

- 指令遵循。通過(guò)對(duì)自然語(yǔ)言描述(即指令)格式化的多任務(wù)數(shù)據(jù)集的混合進(jìn)行微調(diào),LLM 在微小的任務(wù)上表現(xiàn)良好,這些任務(wù)也以指令的形式所描述。這種能力下,指令調(diào)優(yōu)使 LLM 能夠在不使用顯式樣本的情況下通過(guò)理解任務(wù)指令來(lái)執(zhí)行新任務(wù),這可以大大提高泛化能力。

- 循序漸進(jìn)的推理。對(duì)于小語(yǔ)言模型,通常很難解決涉及多個(gè)推理步驟的復(fù)雜任務(wù),例如數(shù)學(xué)學(xué)科單詞問(wèn)題。同時(shí),通過(guò)思維鏈推理策略,LLM 可以通過(guò)利用涉及中間推理步驟的 prompt 機(jī)制來(lái)解決此類任務(wù)得出最終答案。據(jù)推測(cè),這種能力可能是通過(guò)代碼訓(xùn)練獲得的。

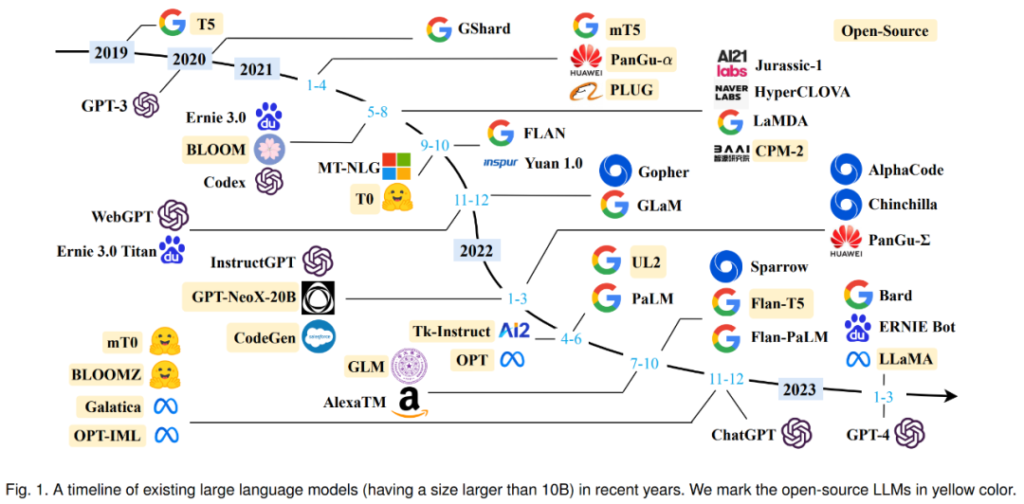

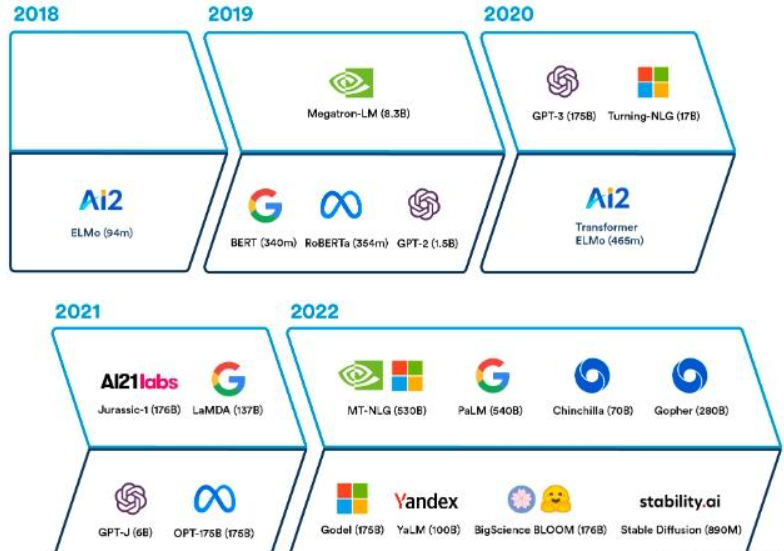

語(yǔ)言模型歷史

2017谷歌推出 transformer 模型,2018 年的時(shí)候谷歌提出了 Bert 的模型,然后到 GPT 2,從 340 兆到 10 億 、15 億,然后到 83 億,然后到 170 億,然后到 GPT3 1750 億的參數(shù)。

最早的是 2017 年出來(lái)的,就是我們所了解的那個(gè)GPT, GPT 名字里面有一個(gè)叫做transformer,就是這個(gè) transformer 模型。它是 2017 年出現(xiàn)的,其實(shí)也很早,所以計(jì)算機(jī)領(lǐng)域來(lái)說(shuō), 2017 年可以歸結(jié)于上一個(gè)時(shí)代的產(chǎn)品。然后 2018 年第一代 GPT 出來(lái),當(dāng)時(shí)還不行,相對(duì)來(lái)說(shuō)比較差,性能也不行,然后像一個(gè)玩具一樣。然后 2018 年谷歌又推出了一個(gè)新的模型,叫BERT,但是這些模型都是基于之前谷歌推出的這個(gè) transformer 模型進(jìn)行發(fā)展的。然后到了 2019 年, open AI 除了 GPT 2 也沒(méi)有什么特別,就是它沒(méi)有辦法來(lái)產(chǎn)生一個(gè)語(yǔ)言邏輯流暢通順的一段名詞,你一看就知道這是機(jī)器寫的。

但是到了 2020 年的5月, GPT 3 出來(lái)之后,其實(shí)就有了非常大的變化, GPT 3 的性能比 GPT 2 好很多,它的數(shù)參數(shù)的數(shù)量級(jí)大概是 GPT 2- 10 倍以上。

LLM的訓(xùn)練方式

訓(xùn)練語(yǔ)言模型需要向其提供大量的文本數(shù)據(jù),模型利用這些數(shù)據(jù)來(lái)學(xué)習(xí)人類語(yǔ)言的結(jié)構(gòu)、語(yǔ)法和語(yǔ)義。這個(gè)過(guò)程通常是通過(guò)無(wú)監(jiān)督學(xué)習(xí)完成的,使用一種叫做自我監(jiān)督學(xué)習(xí)的技術(shù)。在自我監(jiān)督學(xué)習(xí)中,模型通過(guò)預(yù)測(cè)序列中的下一個(gè)詞或標(biāo)記,為輸入的數(shù)據(jù)生成自己的標(biāo)簽,并給出之前的詞。

訓(xùn)練過(guò)程包括兩個(gè)主要步驟:預(yù)訓(xùn)練(pre-training)和微調(diào)(fine-tuning):

- 在預(yù)訓(xùn)練階段,模型從一個(gè)巨大的、多樣化的數(shù)據(jù)集中學(xué)習(xí),通常包含來(lái)自不同來(lái)源的數(shù)十億詞匯,如網(wǎng)站、書籍和文章。這個(gè)階段允許模型學(xué)習(xí)一般的語(yǔ)言模式和表征。

- 在微調(diào)階段,模型在與目標(biāo)任務(wù)或領(lǐng)域相關(guān)的更具體、更小的數(shù)據(jù)集上進(jìn)一步訓(xùn)練。這有助于模型微調(diào)其理解,并適應(yīng)任務(wù)的特殊要求。

常見(jiàn)的大語(yǔ)言模型

GPT-3(OpenAI): Generative Pre-trained Transformer 3(GPT-3)是最著名的LLM之一,擁有1750億個(gè)參數(shù)。該模型在文本生成、翻譯和其他任務(wù)中表現(xiàn)出顯著的性能,在全球范圍內(nèi)引起了熱烈的反響,目前OpenAI已經(jīng)迭代到了GPT-4版本

BERT(谷歌):Bidirectional Encoder Representations from Transformers(BERT)是另一個(gè)流行的LLM,對(duì)NLP研究產(chǎn)生了重大影響。該模型使用雙向方法從一個(gè)詞的左右兩邊捕捉上下文,使得各種任務(wù)的性能提高,如情感分析和命名實(shí)體識(shí)別。

T5(谷歌): 文本到文本轉(zhuǎn)換器(T5)是一個(gè)LLM,該模型將所有的NLP任務(wù)限定為文本到文本問(wèn)題,簡(jiǎn)化了模型適應(yīng)不同任務(wù)的過(guò)程。T5在總結(jié)、翻譯和問(wèn)題回答等任務(wù)中表現(xiàn)出強(qiáng)大的性能。

ERNIE 3.0 文心大模型(百度):百度推出的大語(yǔ)言模型ERNIE 3.0首次在百億級(jí)和千億級(jí)預(yù)訓(xùn)練模型中引入大規(guī)模知識(shí)圖譜,提出了海量無(wú)監(jiān)督文本與大規(guī)模知識(shí)圖譜的平行預(yù)訓(xùn)練方法。

速石科技AI應(yīng)用

AI應(yīng)用落地是所有研發(fā)環(huán)節(jié)中最后一環(huán),也是最重要的一環(huán)。在AIGC應(yīng)用百花齊放的這波浪潮中,速石科技作為MLOps平臺(tái)的提供方,同時(shí)也是其使用方。

速石科技已經(jīng)發(fā)布一款行業(yè)知識(shí)庫(kù)聊天應(yīng)用Megrez,這款聊天應(yīng)用面向企業(yè)客戶提供大語(yǔ)言模型的私有化部署能力,解決了許多企業(yè)用戶關(guān)注的數(shù)據(jù)安全問(wèn)題,它也允許用戶自定義行業(yè)知識(shí)庫(kù),實(shí)現(xiàn)領(lǐng)域知識(shí)的問(wèn)答。

更多可查看:速石科技應(yīng)邀出席2023世界人工智能大會(huì),AI研發(fā)平臺(tái)引人矚目

本文轉(zhuǎn)載:https://zhuanlan.zhihu.com/p/622518771

- END -

我們有個(gè)AI研發(fā)云平臺(tái)

集成多種AI應(yīng)用,大量任務(wù)多節(jié)點(diǎn)并行

應(yīng)對(duì)短時(shí)間爆發(fā)性需求,連網(wǎng)即用

跑任務(wù)快,原來(lái)幾個(gè)月甚至幾年,現(xiàn)在只需幾小時(shí)

5分鐘快速上手,拖拉點(diǎn)選可視化界面,無(wú)需代碼

支持高級(jí)用戶直接在云端創(chuàng)建集群

掃碼免費(fèi)試用,送200元體驗(yàn)金,入股不虧~

更多電子書歡迎掃碼關(guān)注小F(ID:iamfastone)獲取

你也許想了解具體的落地場(chǎng)景:

王者帶飛LeDock!開(kāi)箱即用&一鍵定位分子庫(kù)+全流程自動(dòng)化,3.5小時(shí)完成20萬(wàn)分子對(duì)接

這樣跑COMSOL,是不是就可以發(fā)Nature了

Auto-Scale這支仙女棒如何大幅提升Virtuoso仿真效率?

1分鐘告訴你用MOE模擬200000個(gè)分子要花多少錢

LS-DYNA求解效率深度測(cè)評(píng) │ 六種規(guī)模,本地VS云端5種不同硬件配置

揭秘20000個(gè)VCS任務(wù)背后的“搬桌子”系列故事

155個(gè)GPU!多云場(chǎng)景下的Amber自由能計(jì)算

怎么把需要45天的突發(fā)性Fluent仿真計(jì)算縮短到4天之內(nèi)?

5000核大規(guī)模OPC上云,效率提升53倍

提速2920倍!用AutoDock Vina對(duì)接2800萬(wàn)個(gè)分子

從4天到1.75小時(shí),如何讓Bladed仿真效率提升55倍?

從30天到17小時(shí),如何讓HSPICE仿真效率提升42倍?

關(guān)于為應(yīng)用定義的云平臺(tái):

當(dāng)仿真外包成為過(guò)氣網(wǎng)紅后…

和28家業(yè)界大佬排排坐是一種怎樣的體驗(yàn)?

這一屆科研計(jì)算人趕DDL紅寶書:學(xué)生篇

楊洋組織的“太空營(yíng)救”中, 那2小時(shí)到底發(fā)生了什么?

一次搞懂速石科技三大產(chǎn)品:FCC、FCC-E、FCP

Ansys最新CAE調(diào)研報(bào)告找到阻礙仿真效率提升的“元兇”

國(guó)內(nèi)超算發(fā)展近40年,終于遇到了一個(gè)像樣的對(duì)手

幫助CXO解惑上云成本的迷思,看這篇就夠了

花費(fèi)4小時(shí)5500美元,速石科技躋身全球超算TOP500